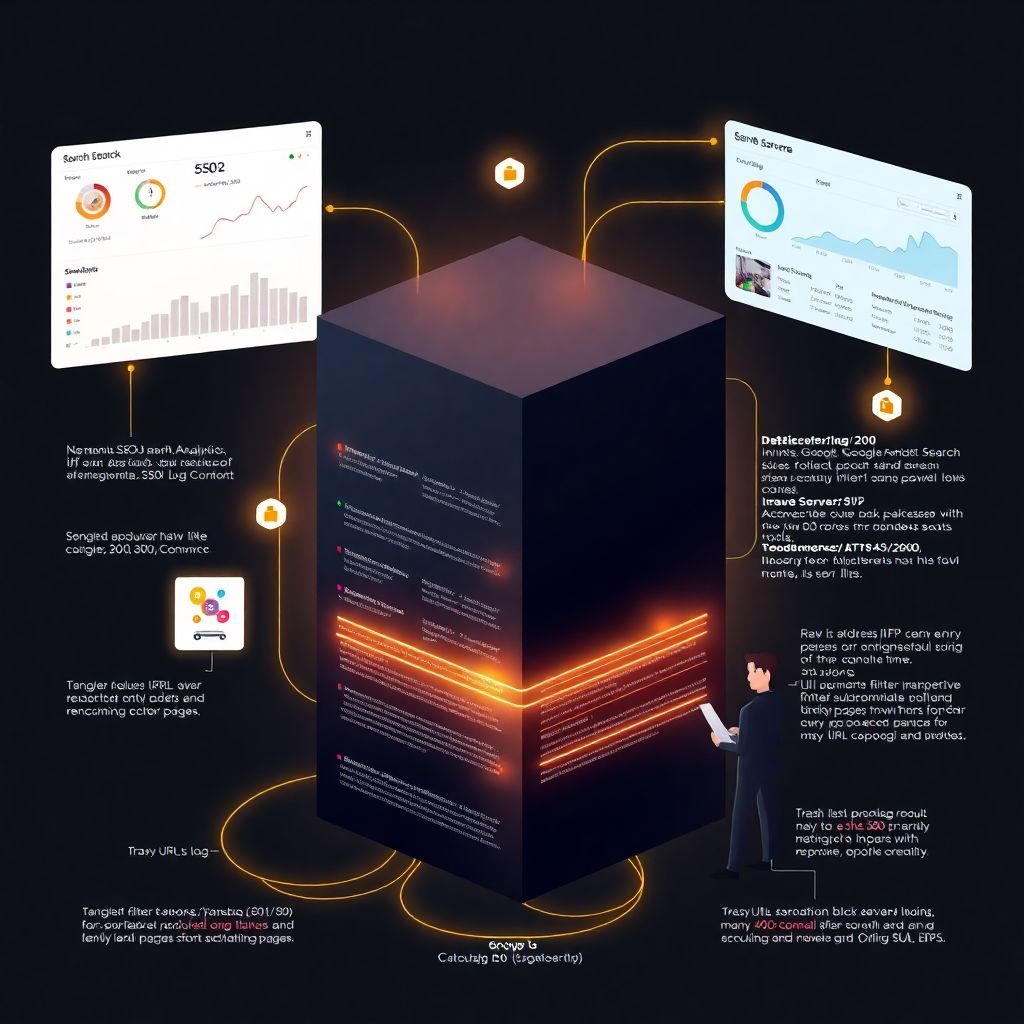

Если упростить до предела, логи сервера — это «черный ящик» вашего сайта. Пока мы смотрим только в Google Analytics, Метрику и Search Console, мы видим уже обработанную картинку. А в логах — сырые события: кто, когда, откуда и что именно запросил у сервера, с каким кодом ответил сайт и сколько это заняло времени. И вот как только вы начинаете системный анализ логов сервера для SEO, картинка резко проясняется: становится видно, как живут поисковые боты на сайте и на что вы впустую тратите краулинговый бюджет.

Зачем вообще трогать логи, если есть аналитика

У многих логика простая: «В Метрике всё видно, в Search Console — тоже, зачем усложнять?». Проблема в том, что классическая аналитика показывает только то, что произошло с пользователем, а SEO зависит еще и от того, как сайт видит робот. Логи — это точка зрения сервера, а не маркетинговых сервисов. Именно поэтому seo аудит по логам сервера часто показывает проблемы, которые не видно ни в одном интерфейсе: лишние редиректы для бота, бесконечные страницы-фильтры, циклы пагинации, которые забивают индекс, или наоборот — важные страницы, до которых поисковики просто не добираются.

Проще говоря, логи отвечают на три болезненных вопроса:

- На что робот тратит время на вашем сайте, а что игнорирует.

- Какие технические косяки реально мешают индексации, а какие можно не трогать.

- Как меняется поведение ботов после доработок — не «по ощущениям», а по факту.

Что даёт анализ логов сервера для SEO на практике

Давайте без абстракций. Представим интернет-магазин с десятками тысяч страниц. Владелец жалуется: «Новые категории не индексируются, старые падают». Без логов можно неделями спорить, кто виноват — контент, ссылки или скорость. А вот что мы реально можем увидеть в логах за пару часов.

1. Видимость сайта глазами робота

В логах чётко видно, какие разделы поисковые боты обходят каждый день, а до каких добираются раз в месяц. Если робот раз за разом ходит на страницы фильтров типа ?color=red&size=xl, зато редко посещает категории и важные посадочные страницы, — индексация будет перекошенной. Это повод переписать внутреннюю перелинковку, закрыть мусорные URL от обхода и подсветить приоритетные разделы.

2. Реальная скорость и стабильность, а не «усреднённые цифры»

В графиках PageSpeed все красиво, а в логах можно увидеть, что часть запросов робот получает с 500-ми ошибками ночью, когда включается резервное копирование или тяжелый импорт. Для человека это почти незаметно, а робот, получая ошибки несколько дней подряд, начинает снижать частоту обхода. Отсюда — медленная переиндексация и затянутое обновление позиций.

3. Лишние редиректы и бесконечные цепочки

Логи безжалостно показывают, сколько раз робот проходит по цепочке 301 → 302 → 200, пока дойдет до целевой страницы. В интерфейсах этого не видно, а поисковик на это тратит краулинговый бюджет. Убирая лишние редиректы, вы буквально «освобождаете кислород» для важных URL, чтобы робот чаще доходил до них и быстрее обновлял данные.

4. Выявление скрытых обходов и «черных дыр»

Иногда анализ логов сервера для seo вскрывает неожиданные вещи: боты активно обходят старый поддомен, о котором уже все забыли, или старые landings, которые давно сняты с навигации, но остаются в sitemap и по внутренним ссылкам. В итоге часть бюджета сливается в никуда. Закрывая эти направления или правильно перенаправляя трафик, можно резко повысить эффективность обхода без единого нового текста или ссылки.

Как проводить анализ логов сервера для SEO: пошаговый подход

Чтобы не превратить всё в бесконечную технарскую историю, проще придерживаться понятного алгоритма. Ниже — базовая схема, которую можно адаптировать под любую CMS и хостинг.

Шаг 1. Достать логи и не сломать сервер

Для начала нужно получить доступ к логам: access.log на Apache или Nginx, журналы на сервере Windows и т.д. Частая ошибка — скачивать гигантские файлы за год вперёд, а потом пытаться открыть их в Excel. Лучше договориться с администратором, чтобы:

- Включили ротируемые логи (например, по дням или по размеру).

- Хранили хотя бы 30–90 дней логов — меньше мало, больше сложно анализировать без автоматизации.

- Настроили сжатие логов, чтобы они не «съедали» весь диск.

Если админа нет, а хостинг простой, логи обычно лежат в панели управления — достаточно выгружать их по расписанию, а потом подгружать в инструменты для анализа логов сервера seo. Да, это рутина, но без неё всё дальнейшее бессмысленно.

Шаг 2. Отфильтровать нужных ботов и отсеять мусор

Следующая задача — отделить полезные запросы от шумовых. Нас интересуют в первую очередь Googlebot, YandexBot и крупные краулеры, которые реально влияют на SEO. В логах обязательно есть:

- Поддельные «боты», которые только прикидываются Googlebot по user-agent.

- Скрипты мониторинга, сканеры безопасности, парсеры конкурентов.

- Обычные пользователи, которых для SEO-анализа логов не всегда нужно учитывать.

Корректный seo аудит по логам сервера всегда включает проверку IP-адресов ботов через официальные диапазоны (Google и Яндекс публикуют правила верификации). Это звучит занудно, но без этого вы можете сделать выводы по фейковым роботам и начать чинить проблемы, которых на самом деле нет.

Шаг 3. Разобрать структуру URL и сгруппировать трафик

Работать на уровне отдельных URL можно лишь в небольших проектах. Как только страниц становится тысячи, мы смотрим по группам: категории, карточки товаров, блог, фильтры, поиск, сервисные страницы. Простейший способ — выделить паттерны в адресах (например, /catalog/, /blog/, /search/) и анализировать частоту и коды ответов по каждой группе. Так видно, какие разделы «обожает» робот, а какие обходятся стороной.

Шаг 4. Собрать ключевые метрики

На практике нас интересуют не десятки показателей, а несколько ключевых:

- Сколько раз за период бот заходил на разные типы страниц.

- Сколько процентов запросов закончились ответом 200, 301, 404, 500 и т.д.

- Среднее время ответа сервера для робота по разделам сайта.

- Глубина обхода: до каких уровней вложенности бот добирается регулярно.

- Динамика: как меняется все выше перечисленное после доработок.

Когда эти цифры собраны хотя бы за месяц, становится гораздо проще связать: вот тут мы изменили структуру меню — и через пару недель робот стал чаще посещать глубоко лежащие страницы каталога. Или наоборот: после установки нового модуля вырос процент 500-х ошибок — и сразу просела частота обхода.

Инструменты для анализа логов сервера SEO: чем реально пользоваться

Технически можно взять чистый Python, пару библиотек и написать свои скрипты. Но если нужны более-менее быстрые результаты, удобнее использовать готовые инструменты для анализа логов сервера seo. Есть облачные сервисы, есть десктопные программы, есть модули в краулерах уровня Screaming Frog или Netpeak Spider. Главное — понимать, что от инструмента вам нужно:

- Умение парсить большие файлы логов без зависаний.

- Фильтрация по user-agent, IP, коду ответа, дате и времени.

- Группировка URL по маскам и директориям.

- Возможность выгружать отчеты в CSV, чтобы дальше копать в том же Excel или BI-системе.

Нестандартный, но рабочий подход — подтягивать агрегированные данные из логов в ту же систему, где у вас лежат клики и конверсии (например, Power BI или Google Looker Studio через промежуточную базу). Тогда можно смотреть не только на то, как ходит робот, но и как на это накладывается реальное поведение пользователей. Так видно, что робот часто обходит раздел, который отлично конвертит, но индексируется медленно, — ему нужно освободить доступ, убрав технический мусор вокруг.

Нестандартные сценарии использования логов в SEO

Чтобы не превращать тему в очередной чек-лист, полезно посмотреть на необычные задачи, которые помогают решать логи. Это уже выход за классическое «посчитать 404 и 500», но именно тут появляется конкурентное преимущество.

1. Приоритизация контента через данные логов

Обычно контент-план строят «от частотности» или от семантического ядра. Но можно сделать хитрее: взять логи, посмотреть, какие разделы робот обходит чаще и стабильнее всего, а какие почти не трогает. В первую очередь усиливать контентом те зоны, куда бот уже регулярно ходит. Это как открыть магазин там, где уже есть поток людей, а не в пустыне. Получается своеобразная «карта тепла» бота по сайту, а контент-менеджер перестает писать тексты на мертвые страницы.

2. Тестирование гипотез по внутренней перелинковке

Перелинковку обычно меняют и надеются на лучшее. В логах можно делать маленькие точечные эксперименты. Например:

- Добавить блок «похожие товары» только для части категорий.

- Изменить навигацию в футере только на одной ветке каталога.

- Включить дополнительные ссылки на важные статьи блога из определенной группы товаров.

Дальше по логам смотрим: увеличилось ли количество заходов бота на эти страницы, сократились ли промежутки между посещениями. Если да — дизайн можно раскатывать на весь сайт. То есть логи превращаются в инструмент A/B-тестов для робота, а не только для пользователей.

3. Поиск паразитного трафика и «ботов-конкурентов»

Это не напрямую SEO, но сильно влияет на производительность. Через логи можно поймать назойливых парсеров конкурентов, которые ходят по тем же страницам, что и поисковики, и забивают канал. Если их запросы вызывают замедление сайта, то робот тоже получает ответы медленнее. Блокировка паразитных ботов через firewall или правила сервера — это косвенное, но реальное улучшение условий для поисковых систем и пользователей одновременно.

4. Контроль миграций и крупных релизов

Любой переезд сайта, смена CMS, массовое изменение структуры URL — это риск. Логи позволяют буквально по часам отслеживать, как реагируют боты: растет ли количество 404 и 500, ходят ли они по старым адресам, не зацикливаются ли на редиректах. Такой мониторинг особенно важен, если вы привлекаете услуги по анализу логов сайта для seo на период миграции. Грамотный подрядчик должен не только прислать отчет «всё ок», но и показать, как боты шаг за шагом адаптируются к новой структуре.

Когда логами должен заниматься подрядчик, а когда — вы сами

Иногда кажется, что логи — это исключительно «админская тема». На деле минимум базовых шагов под силу делать прямо внутри SEO-отдела или даже маркетинга: выгружать логи раз в месяц, прогонять через простой инструмент, смотреть топ-ошибки и ключевые тренды. Но если у вас сложная архитектура, микросервисы, куча поддоменов и мультирегиональность, услуги по анализу логов сайта для seo будут разумной инвестицией. Это как раз тот случай, когда внешнему специалисту проще увидеть системные проблемы, а вам — не тратить недели на изучение форматов логов и командной строки.

Оптимальный сценарий — комбинированный: внешний экспертиза закладывает правила, настраивает регулярный анализ и отчеты, а команда внутри компании потом по этим отчетам уже живет: меняет приоритеты контента, чинит технику, согласует задачи с разработкой.

Минимальный чек-лист по работе с логами для SEO

Чтобы вся теория не растворилась, можно оформить это в короткий рабочий алгоритм, который легко внедрить даже на средних проектах.

- Наладить регулярный доступ к логам (ротация, хранение 1–3 месяца, автоматическая выгрузка).

- Выбрать удобный инструмент и настроить фильтрацию по основным ботам и разделам сайта.

- Раз в месяц смотреть динамику по кодам ответа, скорости и распределению обхода по типам страниц.

- На основе логов формировать список тех задач, которые реально влияют на робота (редиректы, 404, мусорные URL, медленные участки).

- После каждой крупной доработки отслеживать изменения в логах — не по ощущениям, а по цифрам.

Если внедрить это как регулярный процесс, анализ логов перестанет быть «разовой страшной процедурой» и превратится в привычный слой seo аудита. Фактически вы получите «стетоскоп» для сайта: в любой момент можно послушать, как чувствует себя робот внутри вашей структуры и куда сейчас уходит его внимание.

Вывод: логи — не только для админов, а SEO без них теряет половину картины

Логи сервера — это не про экзотическую аналитику для технарей. Это про то, чтобы перестать гадать, как поисковые системы обходят сайт, и увидеть факты. Регулярный анализ логов сервера для seo помогает выжать из уже имеющегося сайта больше: ускорить индексацию важных страниц, освободить краулинговый бюджет от мусора, вовремя ловить технические проблемы и тестировать нестандартные гипотезы по структуре и перелинковке. А дальше уже вы решаете, делать всё своими руками или подключать профильных специалистов — главное, не оставлять «черный ящик» закрытым.