Зачем вообще SEO-шнику смотреть логи?

Если по‑простому: log-анализ — это разбор «черного ящика» сайта. Логи фиксируют каждое обращение к серверу: кто пришёл, что запросил, что ему отдали и с каким результатом.

Для SEO-специалиста это единственный честный источник, который показывает реальное поведение поисковых ботов, а не «где-то примерно».

Когда вы делаете лог-анализ для SEO, вы отвечаете не на абстрактный вопрос «как индексируется сайт», а на конкретный: что именно робот Яндекса и Google реально посещают и что игнорируют.

---

Что такое лог и лог-анализ простыми словами

Определения без зауми

- Лог (access log) — текстовый файл на сервере, где по строкам записаны все запросы к сайту. Каждая строка — одно обращение: браузер человека или робот зашёл по URL, сервер что-то ответил, лог это зафиксировал.

- Log-анализ — разбор этих строк с целью найти закономерности: кто ходит, куда ходит, с каким статусом (200, 301, 404, 500), как часто, как давно и т.д.

- Log-анализ для SEO — это когда вы из логов вытаскиваете только то, что связано с индексацией, сканированием и ошибками, которые мешают росту органики.

Ключевая мысль: аналитика логов — это работа не «по догадкам», а по реальным данным сервера, которые невозможно «приукрасить» интерфейсами.

---

Чем логи отличаются от Google Analytics и других счётчиков

Почему одних метрик трафика мало

Счётчики и веб-аналитика показывают только то, что выполнено в браузере пользователя: JS загрузился, пиксель отработал — сессия зафиксирована.

Поисковый робот не запускает метрику, не грузит JS, не разрешает куки. Поэтому как бы вы ни крутили отчёты в GA, реального обхода роботом там нет.

Логи же фиксируют любой запрос:

Диаграмма (в текстовом виде):

- Веб-аналитика:

- Видит: только людей с включённым JS и счётчиком

- Не видит: ботов, запросы к статике, часть adblock-трафика

- Логи:

- Видят: всех — людей, ботов, сканеры, парсеры, мониторинги

- Не зависят от JS и куки

Вот почему анализ логов сайта для продвижения — это не «опция для продвинутых», а нормальный рабочий инструмент, если вы серьёзно занимаетесь SEO.

---

Зачем SEO-специалисту log-анализ: практический взгляд

1. Понимать, что робот действительно сканирует

Частая ситуация: вы оптимизировали раздел, улучшили тексты, перелинковку, всё красиво. Но позиции не растут месяцами. Логи показывают правду: робот туда вообще не ходит или заходит раз в полгода.

С логами вы можете:

- Найти важные страницы, которые бот ни разу не посещал за период

- Понять, какие разделы поисковик сканирует ежедневно, а какие — игнорирует

- Увидеть, как меняется частота обхода после правок: внедрения sitemap, правки robots.txt, изменения структуры

Это помогает расставить приоритеты: не только «какие страницы важны для бизнеса», но и «каким страницам бот реально уделяет внимание».

---

2. Отловить технические проблемы, которые убивают индексацию

Лог-анализ для SEO очень быстро вскрывает типовые беды:

- Массовые 404 для страниц, по которым ходит робот

- Бесконечные 301/302, где бот крутится по цепочкам

- Страницы с кодом 500, 502, 503, которые в интерфейсах вы не увидите

- Случайно закрытые от ботов разделы, о которых в команде «не знали»

Пример из практики:

Робот Яндекса ходит на /catalog/?page=2, получает 500-ю ошибку, пробует ещё несколько раз, потом снижает частоту обхода всего раздела. В поиске падает количество индексов, трафик проседает, причина непонятна. Логи за минуту показывают: робот упирается в ошибку сервера.

---

3. Оптимизировать краулинговый бюджет

Краулинговый бюджет — это условный «лимит запросов», который поисковик готов тратить на ваш сайт за единицу времени. Если бот тратит его на мусорные URL, он не доходит до важных страниц.

Лог-анализ помогает:

- Отловить параметры, фильтры, сортировки, которые создают тысячи лишних URL

- Увидеть, как робот ходит по пагинации: доходит ли до глубины > 3–4

- Понять, какие разделы «съедают» большую часть визитов бота

Диаграмма «куда утекает краулинг» (словесно):

- Кластер 1: параметризованные URL — 40% запросов бота

- Кластер 2: фильтры с дублями — 25%

- Кластер 3: технические разделы (search, admin и пр.) — 10%

- Кластер 4: реальные посадочные страницы — только 25%

После этого можно точечно править:

- robots.txt

- noindex / canonical

- внутреннюю перелинковку

---

4. Связать поведение бота с изменениями на сайте

Каждый релиз что-то меняет: скорость, структуру, ответы сервера. По логам можно:

- Отследить, упала ли частота обхода после внедрения сложного JS

- Понять, стали ли роботы чаще получать 5xx после перехода на новый хостинг

- Проверить, как быстро поисковики реагируют на новые разделы

Это тот уровень контроля, который вы никогда не получите только из интерфейсов Webmaster/Console.

---

Чем log-анализ лучше и хуже других методов

Сравнение с инструментами для веб-мастеров

Google Search Console и Яндекс Вебмастер дают полезные подсказки: ошибки индексации, проблемы с Sitemap, статистику сканирования. Но это агрегированные и отфильтрованные данные.

В логах — «сырые» события. Там:

- Больше шума (мусорных ботов и запросов)

- Зато можно дойти до уровня конкретной строки: кто, когда, куда, с каким результатом

Поэтому подход такой:

- Вебмастер/Console — обзорная панель: видеть кризисы и общие тренды

- Лог-анализ — «диагностика двигателя»: точная причина, конкретные URL, статусы и User-Agent

Сравнение с краулерами (Screaming Frog, Netpeak и др.)

Краулер — это симуляция поведения бота. Он обходит сайт по ссылкам и показывает, как это мог бы делать поисковик.

Логи же показывают, как это поисковик делает на самом деле.

Комбинация идеальна:

- Краулер: вы строите идеальную карту сайта и видите потенциальные проблемы

- Логи: сверяете эту карту с реальным обходом роботов

---

Практика: как сделать лог-анализ для SEO оптимизации

Шаг 1. Добыть логи с сервера

Варианты зависят от хостинга / сервера:

- Панель управления (ISPmanager, Plesk, cPanel) — обычно там есть раздел «Логи» или «Журналы», откуда можно скачать файлы access.log.*

- Виртуальный / выделенный сервер — логи лежат в /var/log/nginx/ или /var/log/apache2/ (часто файлы формата access.log, access.log.1, сжатые .gz)

- CDN / балансировщик — иногда часть логов там, их тоже нужно учитывать

Важно:

Попросите админа не обрезать User-Agent и referrer, иначе вы не отличите робота от человека.

---

Шаг 2. Отобрать нужный период

Для живых проектов обычно берут:

- 30 дней — чтобы увидеть текущую картину обхода

- 60–90 дней — если у сайта сезонность или редко обновляется контент

Если сайт большой (>1 млн URL), логи могут весить десятки гигабайт. В таком случае лучше брать выборку: например, последние 14–30 дней.

---

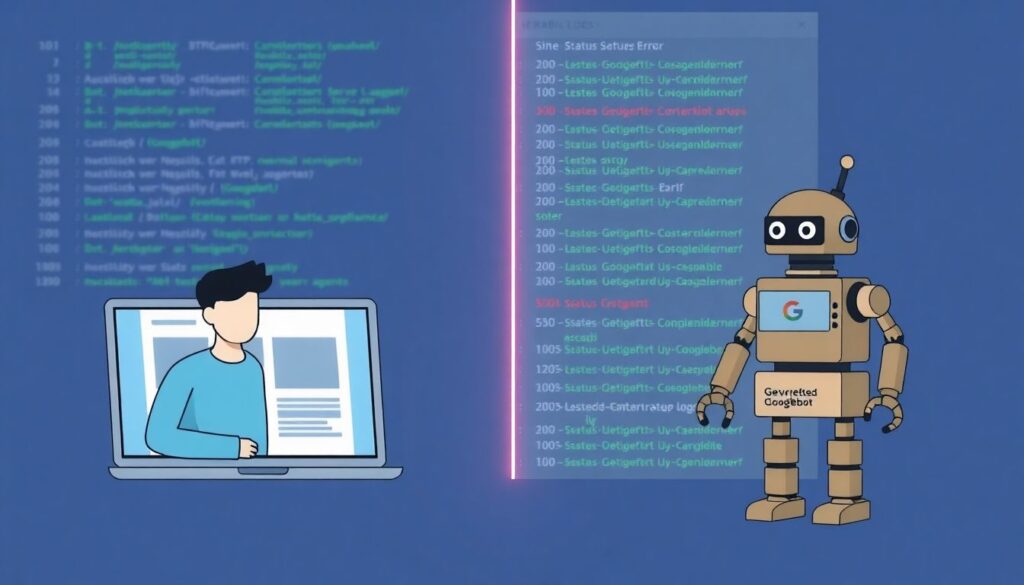

Шаг 3. Отфильтровать поисковых ботов

Для SEO нас интересуют прежде всего:

- Googlebot (mobile и desktop)

- YandexBot, YandexMetrika, YandexImages и др. профильные

- Bingbot, иногда — другие региональные роботы

Фильтрация по User-Agent — базовый шаг. Но умные боты могут маскироваться. Для крупных проектов имеет смысл:

- Проверять IP роботов по официальным диапазонам

- Использовать специализированные инструменты лог-анализа для SEO специалистов, которые уже умеют отличать настоящих ботов от подделок

---

Шаг 4. Собрать метрики, которые реально полезны

Минимальный набор показателей по URL:

- Количество визитов робота за период

- Дата первого и последнего визита

- Распределение кодов ответа (200, 3xx, 4xx, 5xx)

- User-Agent (какой бот ходил)

- Время ответа сервера (если есть в логах)

Хорошая практика — сгруппировать это по типам страниц:

- Категории

- Карточки товара

- Блог / статьи

- Служебные / технические страницы

Тогда вы увидите, где реальная проблема: в продуктовых страницах или, например, во всём блоге.

---

Шаг 5. Сделать выводы и конкретные действия

Вот где лог-анализ для SEO превращается из «отчёта» в инструмент оптимизации. Классические сценарии:

- Если бот почти не ходит в раздел, важный для бизнеса — усиливаем внутренние ссылки, добавляем его в sitemap, убираем лишние ограничения в robots.txt

- Если бот тратит кучу визитов на параметрические URL — закрываем их в robots.txt, добавляем noindex, Canonical или перерабатываем логику фильтров

- Если есть массовые 404/5xx по важным URL — чинит разработчик: редиректы, исправление роутинга, оптимизация бэкэнда

Золотое правило: каждый инсайт из логов должен заканчиваться задачей в трекере, а не просто красивым графиком в отчёте.

---

Какие инструменты использовать и когда звать внешних

Инструменты лог-анализа для SEO специалистов

Вариантов много, можно идти по ступеням сложности:

1. Базовый уровень (для старта)

- Excel / Google Sheets + простые скрипты

- Парсинг логов через регулярные выражения

Подходит для небольших сайтов и первых экспериментов.

2. Средний уровень

- Screaming Frog Log File Analyser

- JetOctopus, LogHero и подобные сервисы

Они уже умеют:

- группировать URL

- фильтровать ботов

- строить понятные диаграммы обхода

3. Продвинутый уровень

- ELK (Elasticsearch + Logstash + Kibana)

- ClickHouse + самописные дашборды

Используется на больших проектах, где нужно обрабатывать гигабайты логов ежедневно.

---

Когда нужны услуги по анализу логов сайта

Имеет смысл привлекать внешних спецов, если:

- У вас крупный проект (маркетплейс, портал, СМИ), а команда разработки и аналитики загружена

- На органическом трафике завязан большой оборот, а просадки видны, но причины неясны

- Нужна архитектура: как хранить, обрабатывать и визуализировать логи, а потом уже поддерживать это своими силами

Профессионалы помогают настроить процесс «под ключ»: от выгрузки логов до понятных SEO-дашбордов, где вы сами будете крутить срезы.

---

Примеры типичных находок в логах

История 1. Бот крутится по бесконечной пагинации

Интернет-магазин, раздел «Каталог».

В логах видно: Googlebot ходит по URL вида /catalog/?page=1,2,3…1000+. При этом реальные товары заканчиваются на 30-й странице. Остальное — пустые листалки.

Последствия:

- Краулинговый бюджет сливается

- До части карточек товаров бот доходит редко

- Индексация хвостов и обновлений тормозит

Решения:

- Ограничить пагинацию (например, не более 50 страниц)

- Добавить rel="next"/"prev" (если уместно для стратегии)

- Перепроектировать выдачу товара (подборки, теги, умная перелинковка)

---

История 2. Ошибка сервера только для ботов

Ситуация: люди спокойно видят страницу, а робот получает 500.

Почему так бывает? На продакшене работало правило, завязанное на User-Agent (например, A/B-тесты или защита от парсеров). Для части ботов это ломало рендер.

В логах:

- Для обычных UA — код 200

- Для Googlebot — 500 на часть запросов

Без логов это почти не заметить: в браузере у всех всё работает. С log-анализом — это буквально два фильтра.

---

Вывод: лог-анализ — это не «доп. опция», а нормальный рабочий инструмент

Если подытожить в прикладном ключе, анализ логов сайта для продвижения даёт SEO-специалисту три главных преимущества:

- Чёткое понимание, как бот реально ходит по сайту, а не как «должен по идее»

- Быстрое выявление технических проблем, которые съедают трафик

- Возможность управлять краулингом и ускорять индексацию нужных страниц

Освоить базовый log-анализ можно за пару недель: научиться добывать логи, фильтровать ботов, смотреть коды ответов и частоту обхода. А дальше вы уже не сможете без него работать — слишком много важных вещей видно только там.

Главное — не относиться к логам как к «технической магии админов». Для SEO это такой же обязательный инструмент, как семантическое ядро или краулер. Разница лишь в том, что лог-анализ тихо показывает правду, которую интерфейсы часто завуалируют.