Историческая справка: от первых серверов до мемов про «ничего не найдено»

Если объяснять ошибка 404 что это простыми словами, то это ответ сервера: «Я жив, но такой страницы у меня нет». Код придумали ещё в начале 90‑х, когда формировался стандарт HTTP. Разработчикам нужно было чётко разделять ситуации: сервер не работает, доступ запрещён, файл временно пропал или ресурса никогда не было. Так появился статус 404 Not Found — он попал в официальный стандарт и быстро стал повседневной частью веба. Со временем вокруг 404‑й выросла целая культура: компании стали делать креативные страницы-заглушки, добавлять шутки, игры и подсказки навигации. Но за красивой обёрткой часто скрывается вполне серьёзная техническая проблема: битые ссылки вредят SEO, портят аналитику и снижают доверие посетителей, если их становится слишком много и никто не отслеживает, откуда они берутся и как долго живут в индексе поисковых систем.

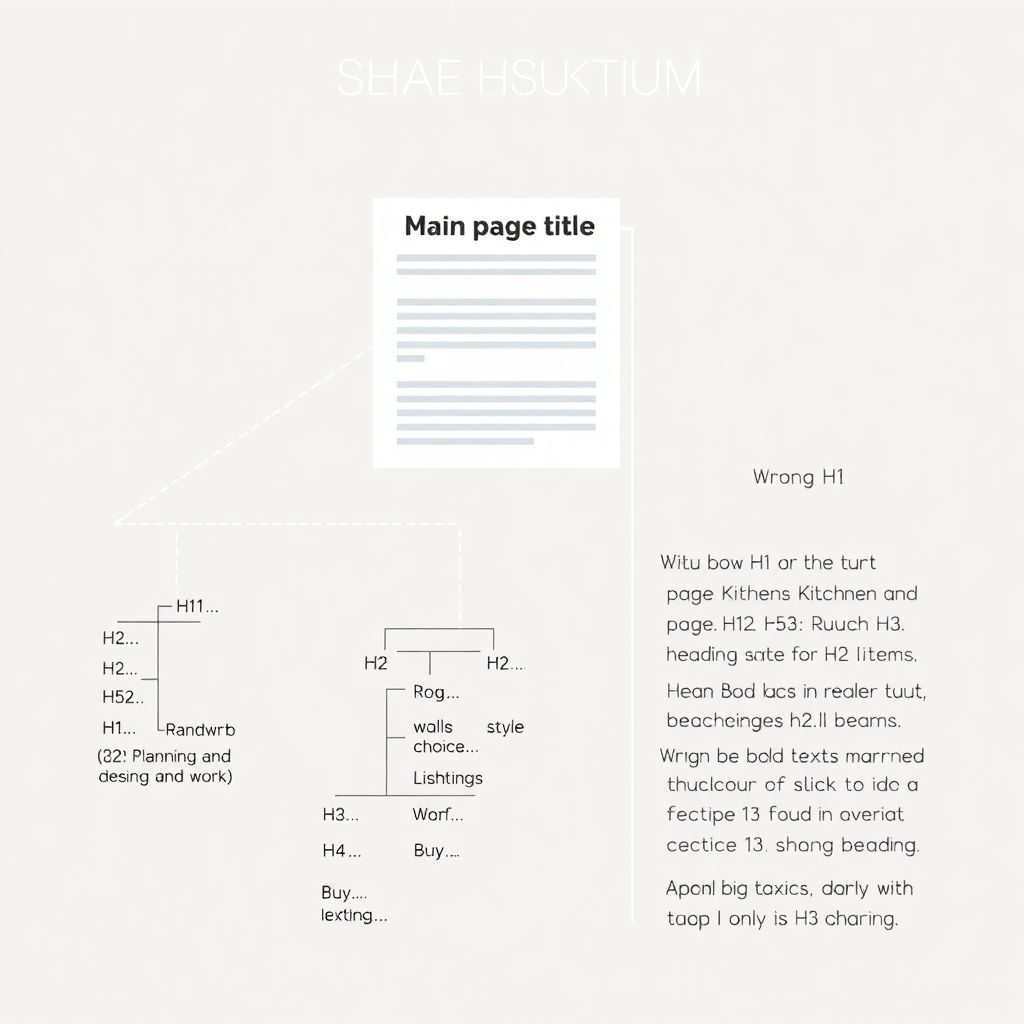

Базовые принципы: как браузер и сервер договариваются о существовании страницы

Когда пользователь нажимает на ссылку, браузер отправляет на сервер запрос: «Отдай мне такой-то URL». Сервер смотрит у себя в конфигурации и файловой структуре: если ресурс на месте, отвечает кодом 200 и выдаёт содержимое; если что‑то не так, возвращает другой статус. Ошибка 404 говорит именно о том, что конечная точка не найдена по указанному пути, а не о поломке самого сайта. Важно отличать 404 от ситуации, когда сервер возвращает красивую страницу «ничего не найдено», но при этом отдаёт код 200 — это логическая ошибка и для поисковиков выглядит как нормальная страница. Для корректной работы статистики и ранжирования необходимо, чтобы все реально отсутствующие материалы честно отвечали кодом 404 или 410. По сути, базовый принцип такой: страница исчезла — меняем ссылки или ставим редирект, а на старом адресе оставляем адекватный ответ сервера, а не визуальный камуфляж без правильного статуса.

Как отслеживать и предотвращать 404: сравнение разных подходов

Методов отслеживания немало, и у каждого свои плюсы и минусы. Простейший путь — смотреть журналы веб-сервера, где фиксируются запросы с кодом 404, но это больше подходит администраторам и требует разбираться в логах. Более дружелюбный способ — использовать встроенные средства аналитики и специализированные службы мониторинга ошибок 404 на сайте, которые собирают статистику, показывают источники проблемных ссылок и даже присылают уведомления. На другом полюсе — полностью автоматизированные системы, которые сами обходят сайт, ищут битые ссылки, предлагают варианты редиректов и интегрируются с CMS. В реальной жизни лучше всего работает сочетание подходов: периодический технический аудит, постоянный сбор данных о живом трафике и настроенные правила перенаправления для популярных старых URL. Такой комбинированный подход и даёт баланс между контролем, затратами времени и качеством пользовательского опыта, особенно если сайт активно развивается и структура меняется чуть ли не каждую неделю.

Онлайн‑сервисы и классические инструменты: от разовых проверок до постоянного мониторинга

Онлайн сервисы для отслеживания 404 ошибок чаще всего работают как внешние роботы‑сканеры: вы указываете домен, сервис проходит по всем доступным ссылкам, фиксирует коды ответа и выдаёт отчёт. Это удобно для периодических проверок, когда нужно быстро оценить масштаб проблем после крупных изменений структуры сайта или миграции на другой движок. В отличие от логов сервера, эти инструменты видят сайт примерно так же, как поисковые роботы, и сразу показывают цепочки переходов, ведущие к ошибкам. Однако у такого подхода есть ограничения: он не видит закрытые разделы, не всегда учитывает динамические параметры и не ловит ситуации, когда пользователь вручную вводит неправильный адрес. Поэтому к внешнему сканированию имеет смысл добавлять внутренние метрики вроде событий в аналитике и записей в системах логирования, чтобы покрыть и поведение реальных посетителей, и структуру сайта целиком, включая редко посещаемые разделы.

Инструменты для проверки ссылок и обработка 404 внутри проекта

Внутри экосистемы сайта помогают инструменты для проверки битых ссылок и 404 страниц, которые встраиваются прямо в процесс разработки или администрирования. Это могут быть плагины для CMS, отдельные скрипты, интеграции в CI/CD или десктопные программы, прогоняющие локальную и боевую версии. Разница между ними в том, насколько глубоко они влезают в логику сайта: одни просто обходят HTML‑страницы и проверяют ссылки, другие анализируют карты сайта, внутренние маршруты и даже API‑эндпоинты. Важный момент — регулярность: одноразовый прогон полезен после редизайна, но настоящую пользу приносит постоянная проверка при каждом крупном обновлении контента или кода. Тогда новые 404 ловятся ещё до того, как ссылки попадают в рассылки, социальные сети или индекс поисковиков, а команда успевает поставить редирект или исправить повреждённый URL до того, как пользователи массово столкнутся с пустыми страницами.

• Внутренние плагины в CMS: удобно для редакторов, всё видно в админке

• Отдельные сканеры: подходят для комплексного аудита больших сайтов

• Интеграция в CI/CD: защищает от появления битых ссылок прямо при выкладке обновлений

Подход «ручной контроль и аналитика»: просто, но трудозатратно

Один из самых прозрачных подходов — ручной контроль: владелец сайта периодически проверяет основные разделы, кликает по ключевым меню и критически важным страницам, а ошибки фиксирует в отдельном списке задач. Такой метод даёт хорошее интуитивное понимание, как сайт ощущается живому пользователю, и позволяет сразу отметить неудобные места навигации. Но у него слабые стороны: он плохо масштабируется, легко что‑то упустить, а редкие страницы и глубоко вложенные разделы остаются вне поля зрения. Усилить этот подход помогает веб‑аналитика: можно настроить цели или события, которые отслеживают попадания на 404‑страницы, и видеть их в отчётах вместе с источниками трафика. Тогда становится понятно, приходят ли люди на несуществующие URL из поиска, со старых внешних ссылок или по опечаткам в собственных материалах. В целом ручной контроль хорошо работает на маленьких и средних проектах, но с ростом трафика и структуры разумно дополнять его автоматизацией, чтобы не тратить время на повторяющиеся проверки.

• Плюсы: минимум технических настроек, всё понятно без специальных знаний

• Минусы: высокая зависимость от человеческого фактора, много «слепых зон»

• Где уместно: лендинги, персональные сайты, небольшие блоги и микропроекты

Автоматизация и профессиональные службы: продвинутый уровень контроля

Там, где ручной подход уже не справляется, на сцену выходят специализированные системы и службы мониторинга ошибок 404 на сайте. Они работают постоянно, собирают данные из разных источников — логов сервера, систем аналитики, crawler‑сканеров — и позволяют выстроить полноценную стратегию управления битым трафиком. В продвинутых решениях доступны фильтры по источникам, географии, частоте появления, а также автоматические алерты, если число 404 резко растёт. Это спасает в ситуациях, когда после релиза новой версии что‑то пошло не так, и половина внутренних ссылок внезапно перестала вести туда, куда нужно. По сравнению с разовыми проверками, такие службы дают историю изменений, помогают увидеть тренды и понять, исчезает ли проблема после правок или только мигрирует из одного раздела в другой. Минус очевиден: более высокие требования к настройке и иногда к бюджету, но для коммерческих и медийных проектов это окупается сохранённым трафиком и меньшим количеством потерянных лидов.

Как исправить ошибку 404 на сайте: основные стратегии и когда что выбирать

Когда встаёт вопрос, как исправить ошибку 404 на сайте, вариантов несколько, и выбор зависит от того, почему страница исчезла. Если материал просто переехал на новый URL, логичным шагом будет настроить постоянный редирект 301, чтобы и пользователи, и поисковики автоматически попадали на новый адрес. Если контент устарел и больше никогда не понадобится, можно оставить честную 404 с понятным объяснением и навигацией по родственным разделам, или использовать код 410, если нужно явно подсказать роботам, что ресурс удалён окончательно. Иногда имеет смысл собрать несколько старых страниц в одну обновлённую и также настроить перенаправления с объединяемых URL. Важно при этом не злоупотреблять перенаправлениями, не выстраивать длинные цепочки и не отправлять людей с любого «мертвого» адреса тупо на главную: это сбивает с толку и пользователю, и поисковым системам. Грамотная стратегия сочетает адресные редиректы для ценных страниц и аккуратные 404 для всего остального.

• Редирект 301 — для переезда контента и сохранения веса старых ссылок

• Код 404/410 — для окончательно удалённых материалов без прямой замены

• Сводные страницы — для объединения похожих или дублирующих публикаций

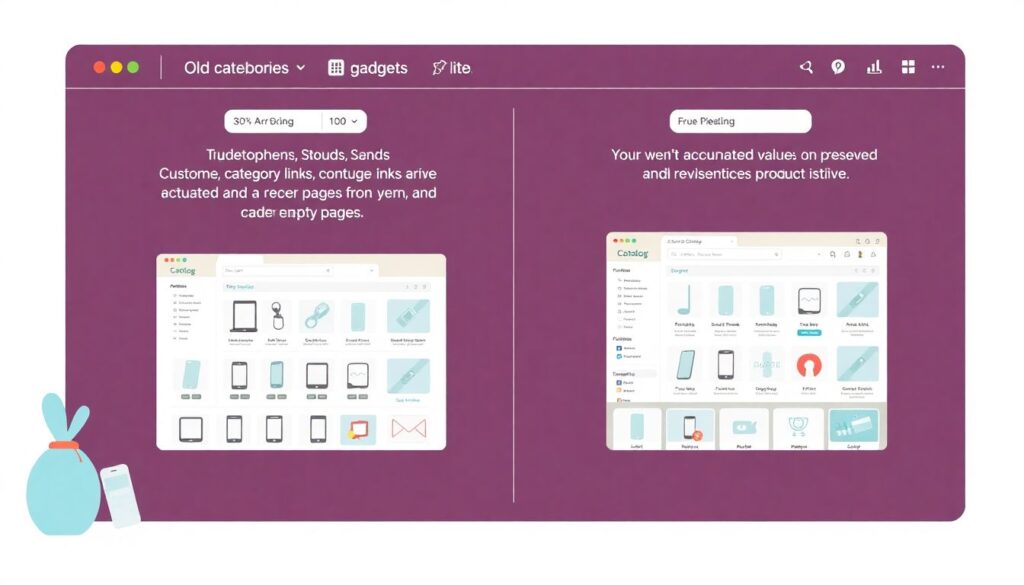

Примеры реализации и сравнение подходов на практике

Представим интернет‑магазин, который меняет структуру категорий: старые разделы «Смартфоны», «Планшеты» и «Гаджеты» объединяют в единый каталог. Можно пойти по простому пути и просто удалить старые URL, оставив их отдавать 404. Это быстро, но покупатели из поиска будут попадать в пустоту, а накопленный рейтинг потеряется. Более взвешенный подход — прописать перенаправления со старых разделов на новые, а самые популярные товарные страницы перевести на актуальные аналоги. Дополнительно на странице ошибки можно разместить поиск по сайту, ссылки на основные категории и блок с популярными товарами, чтобы человек не терялся. В другом сценарии, например в блоге, старые новости о давно прошедших акциях не всегда логично перенаправлять: проще оставить понятную 404, объяснить, что материал устарел, и предложить свежие подборки. Сравнение показывает, что универсального рецепта нет — важно учитывать тип контента, поведение аудитории и ценность каждой конкретной страницы, а не пытаться лечить все 404 одинаково.

Частые заблуждения об ошибках 404 и о том, что на самом деле важно

Одно распространённое заблуждение — думать, что любая 404 автоматически «убивает» сайт в поиске. На самом деле разумное количество корректно отдаваемых 404 — нормальная часть жизни веб‑проекта: страницы устаревают, товары снимаются с продажи, разделы меняются. Проблема начинается, когда ошибок слишком много, они возникают неожиданно и массово или когда вместо реальных 404 сервер отдаёт код 200 вместе со страницей «ничего не найдено». Ещё один миф — что достаточно один раз прогнать сайт каким‑нибудь сканером, и вопрос будет закрыт. На практике структура проекта живёт, появляются новые материалы, меняются адреса, и без регулярного мониторинга всё быстро возвращается к хаосу. Наконец, часто переоценивают способность поисковиков «догадаться», что вы имели в виду, и якобы сами «починить» битые ссылки. Алгоритмы действительно умнеют, но они не заменят акуратные редиректы и продуманную навигацию: ответственность за чистоту ссылочной структуры всегда остаётся на владельце сайта и его команде.

Итоги: как выстроить здравый подход к 404 без фанатизма

Ошибки 404 будут всегда — полностью избавиться от них невозможно и не нужно. Важно превратить их из хаотичного шума в управляемый сигнал: понимать, где именно они возникают, насколько часто повторяются и что теряет бизнес или автор проекта в каждом конкретном случае. Для этого полезно сочетать разные подходы: ручные проверки ключевых разделов, автоматические онлайн сервисы для отслеживания 404 ошибок, систематические инструменты для проверки битых ссылок и 404 страниц, а также осмысленную политику редиректов и удаления контента. Такой комбинированный сценарий позволяет не тратить силы на погоню за нулевым количеством ошибок, а сосредоточиться на том, что действительно важно пользователям: чтобы интересующие их страницы открывались быстро, были актуальны и логично связаны между собой, даже если путь к ним когда‑то менялся и трансформировался вместе с самим сайтом.